Quando falamos sobre o universo e os sistemas naturais, um termo que frequentemente surge é “entropia”. Mas o que exatamente é entropia e por que é tão vital para entender o funcionamento dos sistemas físicos e naturais? Neste artigo, exploraremos em profundidade o conceito de entropia, sua relevância nos processos naturais e sua conexão com a segunda lei da termodinâmica.

Definição

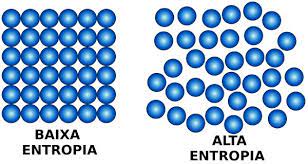

Entropia é uma medida fundamental na física que quantifica a desordem ou a falta de organização em um sistema. Em termos simples, representa a tendência natural dos sistemas para se moverem do estado de ordem para o estado de desordem ao longo do tempo. Quanto maior a entropia, maior é a desordem no sistema.

Segunda Lei da Termodinâmica

A segunda lei da termodinâmica estabelece que um sistema isolado nunca diminui ao longo do tempo; ela só pode aumentar ou permanecer a mesma. Isso implica que, em qualquer processo físico ou químico, a entropia do universo total sempre aumenta. Em outras palavras, os sistemas naturais tendem a se tornar mais desordenados com o tempo, e é isso que a segunda lei da termodinâmica nos diz.

Aplicação na Natureza

A mesma desempenha um papel crucial em diversos fenômenos naturais. Por exemplo, quando um cubo de gelo é deixado à temperatura ambiente, ele eventualmente derrete e se transforma em água. Esse processo é um aumento na entropia, pois o gelo, uma estrutura organizada, se transforma em água, uma forma mais desordenada da matéria.

Além disso, também é fundamental nos processos biológicos. Os seres vivos, de acordo com a teoria da evolução, evoluíram para serem altamente organizados e adaptados ao seu ambiente. No entanto, ainda está em jogo. À medida que os organismos vivos realizam suas atividades metabólicas, geram calor, que é uma forma de energia dispersa e, portanto, um aumento na entropia.

Aplicado a Informação

Também tem uma interpretação interessante no contexto da teoria da informação. Na teoria da informação, entropia é usada para quantificar a incerteza associada a uma variável aleatória. Quanto maior, maior é a incerteza. Quando aplicamos isso à comunicação e codificação de dados, a entropia nos diz quanta informação é necessária para transmitir ou armazenar uma mensagem.

Em resumo, entropia é uma medida crucial de desordem e incerteza nos sistemas físicos, naturais e de informação. É um conceito central na física e na termodinâmica, fornecendo insights valiosos sobre a direção dos processos naturais. Compreender a entropia não apenas nos ajuda a entender o mundo ao nosso redor, mas também é essencial para muitas aplicações práticas, desde a conservação de energia até a transmissão eficiente de dados na era da informação.